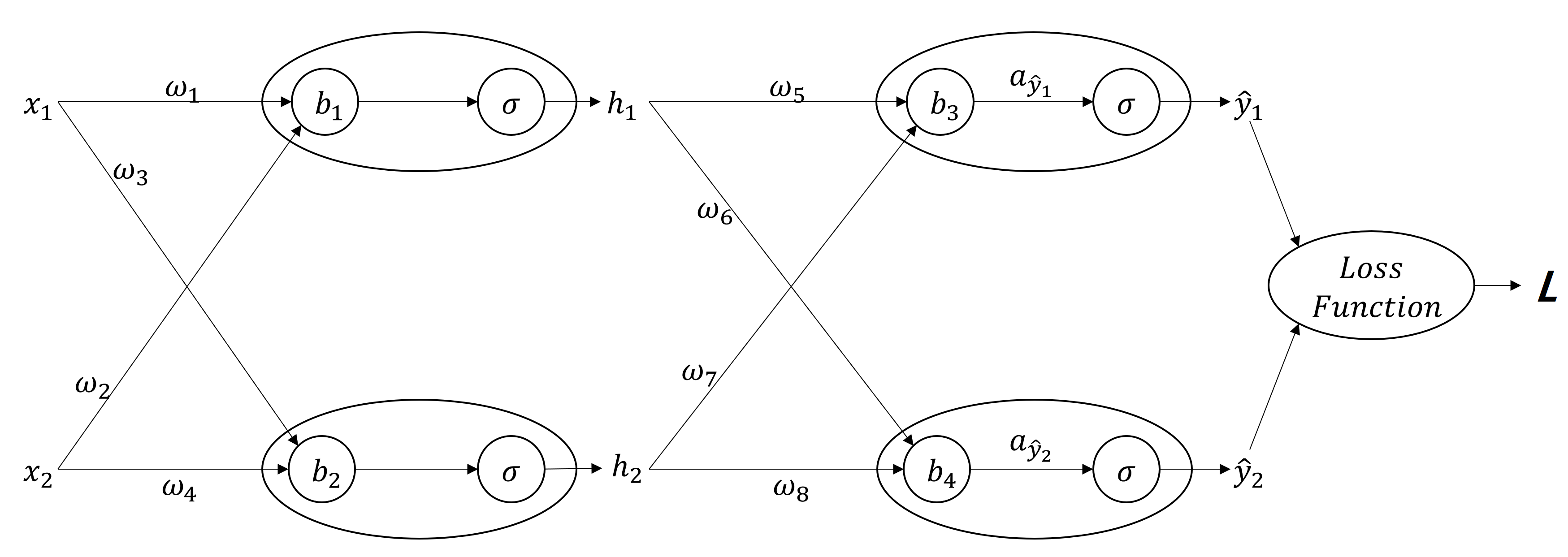

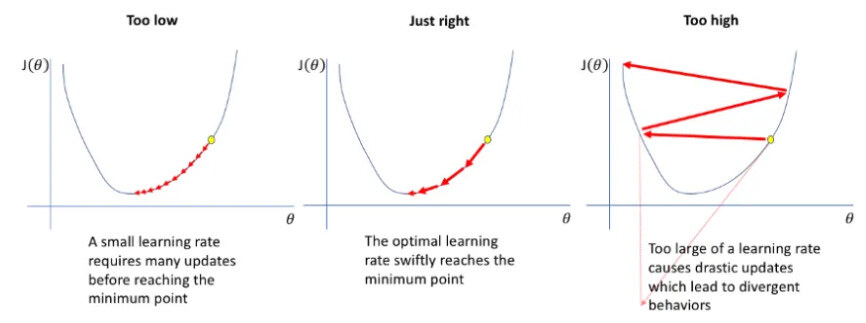

0. IntroductionBackpropagation은 Deep Learning 학습의 핵심 메커니즘입니다.Deep Learning의 학습은 학습하려는 Train Data를 Network에 넣어서 값을 출력하는 순서를 거치게 됩니다.이 과정을 Feedforward라고 합니다. 물론 이 과정에서 출력되는 값은 Network이 학습이 진행되기 전이기 때문에 실제 Target 값과 많이 차이가 나게 됩니다.Deep Learning은 Target 값과 실제 정답과의 차이를 이용하여 Network을 구성하는 Parameter(Weight , Bias)를 적절하게 Update 합니다.이 과정을 Backpropagation이라고 하며, 이번 Post에서는 Backpropagation 과정이 실제로 어떻게 동작하는..